圖解 AI 人工智慧大未來:關於人工智慧一定要懂得 96 件事

- 透過形式主義的手法可以用數學重現人類的理論邏輯思考,

延伸閱讀<數學原理>懷海德(Alfred North Whitehead)與伯特蘭·羅素(Bertrand Russell)。

Chapter 2 自我學習的人工智慧

- 所謂監督式學習就是同時提供問題與答案讓人工智慧學習問題解決的方法。

- 強化學習讓人工智慧依照點數的增減來做自我評估,

如此,就會讓人工智慧朝著增加點數的方向學習。

Chapter 4 深度學習的誕生

- 類神經網路有別於傳統人工智慧技術,歷經長達60年的淬鍊,終於開始發揮它真正的價值,

也就是「深度學習」的誕生。

- 反向傳播法(Backpropagation)、卷積神經網路(Convolutional Neural Network)、

自動編碼器(Autoencoder)這三個技術是深度學習的研究基礎。

類神經網路的「調節計算」與「反向傳播」技術

- 克服單層感知器限制的是「反向傳播」技術的開發,透過與神經網路多層化的連結,

克服了原本「只能處理現應分割問題」的缺陷。

- 感知器在突觸間「加權計算」的研究上很受到矚目,但當要處理的規模變大時,

感知器就很難找出最適當的加權(也稱為權重),而用來解決此問題的方法也就是「反向傳播」技術。

- 首先確認類神經網路某一組輸入值對應的輸出值,與正確解答間的誤差為何。修正誤差時,

從輸出層反向對輸入層的加權計算做修正,因此稱為「反向傳播」。

- 傳遞錯誤訊息的人會給予較低的權重(降低點數),而對傳遞接近正確訊息的人給予

較高的權重(增加點數),一直修正到最初傳遞訊息的人(輸入層的突觸)為止。

- 反向傳播法技術並不是萬能的,其用來修正誤差的方式也只適用「監督式學習」,

而且無法有效處理4層以上的類神經網路。也就是說,其有效處理的部分只有3層的類神經網路。

實現多層次類神經網路的「卷積神經網路」

- 單層突觸無法解決的問題必須靠多層突觸解決,也就是說,藉由層次的增加,

讓處理資料的運用可以更「廣」也更「深」。卷積神經路時現類神經網路的多層化,

讓人工智慧得以做到影像辨識。

- 類神經網路的各層扮演著諸如「角度分析」、「曲線分析」、「直線分析」工作的角色,

最後再將各種特徵做綜合比較並重現類似人類辨識的能力。

突破多層次限制的「自動編碼」技術

- 為處理4層以上卷積神經網路無法有效運作問題,解決的方法就是利用「自動編碼器」技術,

就由「編碼」(壓縮)與「解碼」(解壓縮)的方式帶來了出奇的效果。

- 「自動編碼器」技術的另一個重點是資料編碼。編碼就是把整體的符號數變少,

也就是做資料的「壓縮」。事實上,「做壓縮」就等於是「辨識特徵」,不但可以刪除不必要的資料,

也可以減少傳遞錯誤資料的可能性。

深度學習的誕生與特徵取出能力

- 「深度學習」也可以說是把人工智慧用在,篩選、擷取和分析「卷積神經網路中」

每一層資料的特徵。這項革命性技術讓原本只能由人力輸入的參數設定(特徵擷取),

改為透過機器學習來處理。

藉由深層強化學習提升「辨識力」

- 深度學習與強化學習結合就變成「深度強化學習」。所謂的強化學習,就是要讓人工智慧

反覆錯誤中學習並給予過給予獎勵來接近市場目標的學習方法,

主要運用在遊戲或路徑搜尋等在特定環境行動的人工智慧。

- 而「深層強化學習」的最大特點就是深度學習的特徵擷取。

擅長影像辨識的「卷積神經網路」

- 在多層次類神經網路中,最具代表性的就是「卷積神經網路」(CNN,Convolutional Neural Network),特別適用於影像辨識CNN的特點就是擅長強調特徵處理。採用「卷積」的處理方式,會把影像的特徵(如形狀、顏色、樣式等)先做分類,然後再強調特徵的部分,之後再藉由特徵來比較判斷

「此特徵是屬於什麼影像」。換句話說,卷積處理可以除去不必要的資料。

- 卷積神經網路除了「卷積處理」外,還有另一個「池化」(Pooling)技術,也就是先確認影像特徵

(如形狀、顏色、樣式等)的組合方式,然後再統整為一個資料來處理。在把影像切割成細小像素再組合的部分與卷積的方式一樣,但在影像處理上是不同的。「池化」是把影像的解析度降低處理,而「卷積」只是把特徵的為小部分保留組合起來,並不會改變影像的解析度。

機器翻譯的革命技術「循環神經網路」

- 「循環神經網路」(RNN:Recurrent Neural Network)擅長處理自然語言,

「循環」就像是雞生蛋、蛋生雞的關係,結果就是原因的一種循環。這和程式語言的「遞迴」概念相同。人工智慧在理解句子時,最大的問題就是單字的意思會隨句子變化。

譬如把「我養貓」分成「我」、「養」、「貓」,每個字有自己的意思,

而字與字之間的組合也有其關係性,全部合起來就構成一整句的意思。這裡就出現了所謂的循環性:

如果不知道單個字的意思就不知道彼此的關聯,而不知道彼此的關聯就不知道單個字的正確意思。

將單字與文章的意思「向量化」

- 藉由「循環神經網路」讓人工智慧可以翻譯出更流暢的自然語言,為了更進一步提升其翻譯能力,

開始了將單字與句子含意「向量化」的研究。

人工智慧藉由可自由使用的資源而持續進化

- 深度學習帶給人工智慧研究的衝擊因研究成果採用開放原始碼形式而更加快速。

譬如Google所提供的TensorFlow,透過Open Source(開放原始碼)的軟體函式庫,無論是誰都可以自由使用或是將其商業化。其他像是日本新創公司Preferred Networks提供Chainer、加州大學柏克萊分校釋出的Caffe等軟體框架(Framework)或函示庫,也紛紛採用開放原始碼方式。

2020年3月21日 星期六

2020年3月13日 星期五

文科生也看得懂的資料科學

文科生也看得懂的資料科學

Numsense! Data Science for the Layman: No Math Added

Numsense! Data Science for the Layman: No Math Added

Ch01|基本知識簡單說

- 資料科學研究有四個關鍵步驟:

一、準備資料

1.1 準備資料

- 變數類型:二元變數、、類別變數、整數變數、連續變數

二、選地適當的演算法來模擬資料

2.1 挑選演算法

- 非監督式學習:當我們試圖找出資料集中潛在的模式時,可以使用非監督式學習類的演算法。

這類演算法之所以是「非監督式的」,是因為我並不知道要找出哪些模式,

所以需要使用這類演算法來找出資料中有哪些模式(Pattern)。

- 監督式學習:如果想要進行預測,可以運用監督式學習的演算法。

這類演算法之所以是「監督式的」,原因在於我們希望演算法根據已經存在的模式進行下一步預測。

- 強化學習:在非監督式學習與監督式學習中,模型學習並實際應用後便不再做任何變動。

與前兩者不同的是,增強學習會不斷地根據結果反饋逐步自我精進(優化預測)。

三、調整演算法參數,優化模型

四、評估模型的準確度

4.1 評估結果

*類別指標

- 正確預測百分比

- 混淆矩陣:混淆矩陣能更進一步幫助我們理解預測模型成功與失敗之處。

在下表中,儘管整體分類準確性高達90%,這個模型在預測「不會購買」的表現顯然比預測「實際購買」的表現還要好得多。同時可以發現預測誤差平均分布在偽陽(false positive)

和偽陰(false negatives)之間,各存在五個誤差。

- 接收者操作特徵曲線下的面積:也被稱為曲線下面積(AUC),這個評估指標有助於選擇最大化真陽性率或是最小化偽陽性率。

-- 可以利用接收者操作特徵曲線(ROC曲線)將這個取捨視覺化處理,如下圖所示。

-- 實際應用上,可以認定最佳預測模型為產生最大AUC值的模型,然後利用預測模型的ROC曲線,

為我們願意接受的TPR值或FRR值選擇適當的閥值。

- ROC曲線允許我們選擇欲避免的錯誤類型,另外,也可以使用「對數損失」指標來懲罰所有錯誤的預測。

- 對數損失:通常二元變數和分類變數的預測值以機率表示,例如消費者購買魚類的機率。

機率越接近100%,預測模型對於消費者購買魚類這件事情越有信心。

「對數損失」指標利用這個信賴水準來校正對錯誤預測的懲罰一具體而言,當預測模型對於錯誤預測越有信心,對於「對數損失」的懲罰越嚴重。

*迴歸指標

- 方均根差(RMSE,Root Mean Squared Error):當迴歸預測使用連續變數時,誤差通常會被量化為預測值與實際值的差,而懲罰參數也會影響誤差程度。

方均根差是廣受青睞的迴歸指標,且在試圖避免大型誤差時特別好用,因為將所有獨立誤差平方,從而放大了大型誤差。這項特性使得均方根差對於異常值特別靈敏,也使得異常值將被嚴重懲罰。

- 平均絕對誤差(Mean Absolute Error,MAE):一種評估迴歸模型的簡單方法是在所有資料點取平均預測值和實際值之間的差距,平均處罰所有錯誤。這個測量指標被稱為「平均絕對誤差」。

- 均方根對數誤差(Root Mean Squared Logarithmic Error,RMSLE):除了使用「均方根誤差」指標,對大型誤差加強懲罰之外,還可以使用「均方根對數誤差」(RSMLE)來解釋誤差的方向。

如果想要避免低估情勢,好比在雨天預測雨傘需求,即可使用「均方根對數誤差」。低估情勢會造成顧客不滿和收入損失,相較之下,高估情勢只會造成額外庫存。

*驗證

- 交叉驗證:將資料集劃分為多個用來重複測試模型的資料片段,最大化可用於驗證的資料。

在單次迭代中,除了一個片段之外,將所有其餘片段用來訓練該預測模型,

然後對最後一個面段進行測試。這個驗證過程將被重複,直到每一段都恰好當過一次測試片段。

Ch02|k-平均分群演算法(k-means clustering)

2.3 定義群集

- 群集數量必須大到足使我們取得具有意義的模式,為商業決策提供建議,同時群集數量也必須小到足以確保各群集具有明顯的獨特性。

- 陡坡圖(scree plot)可用來決度群集的適當數量,透過陡坡圖可以觀察到,當群集數量增加時,群集內的散佈情形隨之減少。在陡坡圖中,使曲線急遽轉彎的點被稱為「扭結」(kink),它的位置意味著群集的最佳數量,以及群集內散佈情形被控制在合理範圍。

2.4 先天限制

- 每個資料點只能被分到一個群集:有些時候,某個資料點可能恰好位於兩個群集的中間,被分配到任一群集的機率是一樣的。

- k-平均分群演算法將群集預設為球形:尋找距離資料點最近的群集中心的此一迭代過程相當於將群集的半徑限縮在某一範圍內,因此最後所得到的群集就像是緊密的球形。

- 預設群集是離散的:k-平均分群演算法不允許群集相互重疊,也不可能出現某一群集內嵌於另一群集之中的情形。

Ch03|主成份分析(PCA,Principal Component Analysis)

- 主成分分析是一種找出對資料點而言最具識別度的潛在變數(也就是主成分)之探勘法。

這些主成分(Principal Component)即是能讓資料分散地最廣的維度。

- 每個主成分(PC)都是將營養變數進行加權組合後得到的值,加權係數可以為正、負,或接近零。

舉例來說,若想得出某個食物品項的第一主成分(PC1)的數值,我們必須以下列式子求值:

0.55(纖維)+0.44(維生素C)-0.45(脂肪)-0.55(蛋白質)。

- 因此,與其使用我們先前反覆嘗試合併變數的做法,主成分分析可以為變數計算出精確的加權係數,

告知我們可以合併那些變數,以利識別資料。

- 主成分的最佳數量由陡坡圖決定。

- 主成分分析(PCA)是一種降維技術,因為它幫助我們以較小的變數集來呈現資料,而這些變數被稱為主成分。

3.4 先天限制

- 散佈極大化:主成分分析最重要的假設就是,讓資料點最廣泛分散的維度是最有效的。

然而,這個假設不一定為真。最有名的反例就是計算堆疊在一塊兒的鬆餅數量。

- 詮釋成分:主成分分析法的關鍵挑戰是必須為生成成分做詮釋,然而有時候,我們可能很難解釋為什麼變數未以某種方式組合。

- 主成分戶為直角:主成分分析所產生的都是呈直角相交的主成分,表示主成分之間呈90度。

然而,這個假設並不全面,因為資訊維度並不總是直角相交。要解決這個限制,

可以使用獨立成分分析(ICA)作為替代方法。

Ch04|關聯規則

4.1 找出消費模式

- 了解不同的消費模式有助於商家提高產品銷售量。舉例來說,假如X和Y這兩個商品經常被一起購買:

-- X商品的廣告可以投放給Y商品的消費者。

-- 可以將X和Y商品擺放在同一架上,刺激消費者同時添購兩項商品。

-- X和Y商品可以組成新產品,比方說Y口味的X商品。

4.2 支持度、可信度與作用度

- 有三個常用指標可衡量關聯性

* 指標1:支持度(Support)

- 這項指標表示項目集出現的頻率,衡量該項目集出現在所有交易的比例。

{X}的支持度代表項目X的出現頻率

* 指標2:可信度(Confidence)

- 這項指標呈現當項目X出現時,項目Y也出現的頻率。

{X->Y}的可信度代表當項目X出現時,項目Y也出現的頻率。

* 指標3:增益(Lift)

- 增益這個指標表示項目X與項目Y同時出現的頻率,同時考量各項目各自出現的頻率。

{X->Y}的增益值表示項目X與項目Y同時出現的頻率,同時也考量各項目各自出現的頻率。

4.4 先驗原則

- 降低需要考量的項目集數量的方法是善加利用先驗原則(apriori principle)。

簡單來說,先驗原則認定,如果一個項目集是不頻繁的,那麼包含這個項目集的任何項目集都是不頻繁的。這意味著若{啤酒}被認為是不頻繁的,那麼{啤酒、披薩}也一定是不頻繁的。

由此一來,我們不再需要將{啤酒、披薩},或任何包含啤酒的項目集納入考量,簡化頻繁項目集清單。

4.5 先天限制

- 運算成本高:儘管先驗原則可以有效降低需要考量的候選項目集數量,當產品數量很多,或者支持度閾值太低時,等待運算的候選集數量仍然非常可觀。一個替代方案是使用進階資料結構法,更有效地篩選後選項集,減少比較次數。

- 虛假關聯:項目的關聯性也可能隨機發生於大量項目中,必須進行驗證步驟,確保這些被找出的關聯具有通則性。

Ch05|社群網路分析(Social Network Analysis,SNA)

- 社群網路分析的潛在應用有:病毒式行銷、傳染病擴散模型,或團隊遊戲策略等領域。

不過,最為人所知的應用還是分析社群網路之間的關係,這也是該演算法的命名由來。

5.3 Louvain 演算法

- 為了方便視覺化處理貿易網路,需使用一個強制導向演算法:不具連結的節點之間會相互排斥,

而具有連結的節點會根據連結強度相互吸引。

- Louvain演算法是辨識網路內群集的一種方法。使用不同的分群配置進行實驗,以滿足

(1)最大化同一個群集內,節點之間「邊」的強度與數量,同時

(2)最小化不同群集間「邊」的強度與數量。滿足這兩個條件的程度被稱為模組性,越高的模組性代表更加優化的群組。

- 當群集的大小且離散度一致時,Louvain 演算法的效益最佳。

- Louvain 演算法的先天限制

-- 重要但小的群集可能被吸收了:群集的迭代合併可能會導致重要但小的群集被忽略。

為了避免這種情況,可以檢驗在中間迭代階段時被確認的群集,並在必要時保留他們。

-- 多種可能的群集配置:對於包含重疊或巢套群集的網路來說,可能難以確定最最佳分群方案。

儘管如此,當出現多個高度模組化的解決方案時,我們可以根據其他資訊來驗證群集,就像我們利用國家的地理位置和政治意識形態的相似之處。

5.4 PageRank 演算法

- PageRank演算法雖然易於使用,卻有一個缺點:它傾向於偏袒舊節點。

- PageRank演算法根據連結數量、連結強度與連結來源,對網路中的節點進行排名。

雖然這可以幫助我們確定網路中的主要節點,但是也會對較新的節點產生偏見,因為這些新結點建立實質連結的時間較短。

Ch06|迴歸分析(Regression Analysis)

6.3 梯度下降

- 梯度下降(Stochastic Gradient Descent)演算法在一開始,先推測一組合適的權重,然後進入迭代階段,將這些權重套用到所有資料點來進行預測,接著微調權重,減少整體預測誤差。

除了應用於迴歸分析之外,梯度下降演算法也可以用來優化其他模型參數,例如支持向量機和神經網路。在這些更加複雜的模型中,從何處開始下降(如:初始參數值)可能會影響梯度下降的結果。

- 為了降低陷入凹處的風險,可以使用隨機梯度下降(Stochastic Gradient Descent)與其他使用「所有」資料點於每次迭代中調整參數,現在我們只使用一個資料點做為參考。

6.4 迴歸係數

- 迴歸預測因子的權重的正式名稱為「迴歸係數」(Regression Cofficient)。

迴歸係數表示當其他預測因子存在的情況下,該預測因子的強度。換句話說,這是指該預測因子的附加價值,而不是該預測因子的絕對預測能力。

- 以不同單位測量的預測因子也會干擾我們對迴歸係數的解釋。舉例來說,同一個預測因子以公分為單位預測,和以公尺為單位來預測,兩個值之間就相差了100倍。為了避免這種情況,在進行迴歸分析之前,必須將預測變數的單位標準化。標準化等於以百分位表示每個變量。

當預測變量被標準化後,它們的係數被稱為beta權重,可以進行更精準的比較。

6.5 相關係數

- 如果只有一個預測因子,則該預測因子的beta權重稱為相關係數(correlation coefficient),

以r符號表示。相關係數為-1至1之間的值。

- 因為相關係數表示單個預測因子的絕對強度,它們比迴歸係數更為可靠,可用來排序預測因子的影響力。

- 趨勢線由預測變量的加權組合推導而出。權種被稱為迴歸係數,代表在其他預測變量存在的情況下,

某預測變量的預測強度。

- 當預測變量之間不具相關性,沒有異常值,且預期趨勢是一條直線時,迴歸分析的效益最佳。

6.6 先天限制

- 對異常值很敏感:由於迴歸分析對所有資料點一視同仁,少量的極端值就可能嚴重影響趨勢線走向。

為了避免這個情況,在進一步分析之前,可以先利用散佈圖找出異常值。

- 相關預測因子的權重被扭曲:擁有高度相關的預測變數的迴歸預測模型會扭曲對於權重的解釋,

導致多重共線性(Multicollinearity)問題。

為了解決多重共線性問題,可以在進行迴歸分析之前,事先排除相互關聯的預測因子,或者使用更先進的技術,例如lasso或ridge迴歸。

- 曲型趨勢:在上述的預設房價案例中,趨勢線皆為直線。不過有些趨勢線可能是曲型的。

這時我們需要轉換預測值,或使用如支持向量機等其他演算法來解讀趨勢線。

- 預測因子和結果並不暗示因果關係:假設住戶使否養狗被實證與房價有正相關性。我們清楚明白飼養一隻狗並不會增加房屋價值,相對地,有能力飼養狗的家庭往往有著更高的收入,而且可能居住在房價較高的富裕地區。

Ch07|k-最近鄰演算法與異常檢測(K-Nearest Neighbors,K-NN)

- k-最近鄰演算法是一種根據鄰居的類別,對資料點進行分類的演算法。如果一個點被四個點和一個黑點包圍,那麼,按照「近朱者赤,近墨者黑」的多數決概念,該資料點應該是紅色。

7.4 異常檢測

- k-最近鄰演算法不僅可以預測資料的分類或連續值,還可以辨識異常值,偵測是否有詐欺情事。

此外,辨識異常值這件事還能延伸出額外洞察,就像發覺之前被忽略的預測因子。

7.5 先天限制

- 類別規模不一致:如果某個研究中有多個需要預測的類別,而且各類別的規模差異甚大,那麼屬於小類別的資料點可能會被大類別的資料點覆蓋,導致較高的分類錯誤風險。

為了提高準確性,可以使用加權投票而非多數決的方式,確保近鄰類別的權重比遠鄰更重。

- 過量的預測因子:如果需要考量的預測因子太多,那麼在多個維度上識別和處理最近鄰,在運算上是一件相當艱鉅的任務。此外,有些預測因子可能是多餘的,無法提升預測準確性。想要解決這個問題,可以利用「降低維度」,篩選出最為強大的預測因子,然後再進行分析工作。

Ch08|支持向量機(Support Vector Machine,SVM)

- 支持向量機演算法有一個關鍵特徵,也就是「緩衝區」,允許有限數量的訓練用資料點分佈在不正確的另一側。這個特徵讓邊界更具「彈性」,更能穩健處理異常值,使該預測模型對新資料具通則性。

- 支持向量機使用核技巧(Kernel Trick)的方法倒出複雜的曲線模式。支持向量機將資料投影到更高的維度上,讓資料點可以使用直線區分,而不是直接在資料平面上繪製曲面邊界。這些直線計算起來更為簡單,而且投影到較低維度時也很容易轉換成曲線。

- 支持向量機具有處理高維度資料的能力,有助於分析具有眾多變量的資料集。它的常見應用包含解碼遺傳資訊,以及評估文本中的情感。

- 支持向量機(SVM)在兩組邊緣資料點(支持向量)之間,畫出一條分界線,將資料點分成兩組。

- 當大樣本的資料點必須分為兩個不同的組時,最適合使用支持向量機演算法。

8.4 先天限制

- 小資料集:由於支持向量機仰賴支持向量來決定決策分界線,所以小樣本意味著能夠用來準確定位邊界的邊緣資料點更少。

- 多個分組:支持向量機一次只能將資料分類成兩組。如果多於兩組,則需要透過多分類支持向量機進行迭代來區分每一組資料。

- 組間大量重疊:支持向量機根據資料點於決策邊界的哪一側,偽資料進行分類。當兩組分類的資料點之間存在大量重疊時,靠近邊界的資料點容易於被錯誤分類。此外,支持向量機演算法無從得知每一個資料點被錯誤分類的機率。不過,我們仍然可以根據某一資料點與決策邊界的距離,衡量該資料點被準確分類的可能性。

Ch09|決策樹

9.3 產生一棵決策樹

- 重複分割資料,取得均勻群組的過程稱為遞迴區分(Recursive Partitioning)。

這個過程只涉及兩個步驟:

步驟1:找出可以最能將資料點均分的二元問題。

步驟2:在每一個葉節點重複步驟1,直到達成停止條件。

- 因為二元問題以中心值為基準來區分資料點,因此決策樹可以有效處理異常值(極端值)。

9.4 先天限制

- 不穩定性:因為決策樹是透過分割資料點以獲取均勻區分的群組,若是資料出現些許變動,很可能導致分割出現變化,得到完全不同的決策樹。同樣地,正因為決策樹會使用最佳問題來分割資料,所以預測結果常常出現「過適」。

- 不準確性:一開始即使用最佳二元問題來分割資料的作法可能無法推導出最準確的預測。

在決策樹初始時,使用不太有效的分隔,反而能在最後得到更好的預測。

-為了克服這些缺陷,我們可以避免在每一次分割時追求最佳效果,讓樹狀圖多樣生長。

之後再將不同決策樹的預測合併,合併後的預測結果具有更好的穩定性與準確性。

- 有兩種讓決策樹多樣生長的方法:

1. 第一種方法是隨機選擇不同的二元問題組合來產生多個決策樹,接著將這些樹所產生的預測加總。這總方法被稱為隨機森林。

2. 第二種方法則是策略性地選擇二元問題,遞增式改善後續每顆樹的預測準確性。最後衡量所有預測的加權平均值,得到預測結果。這種方法稱為梯度提升(gradient boosting)。

- 儘管隨機森林和梯度提升兩種方法可以產生更精確的預測結果,但他們太過複雜性使得預測結果更難以視覺化。因此,他們常被稱為「黑箱」。這就解釋了為什麼決策樹仍是一個熱門的方法,因為決策樹容易視覺化處理,讓人們更簡單直覺地評估預測變量和變量之間的相互作用。

Ch10|隨機森林

10.1 群眾的智慧

- 這建立在「儘管有眾多可能的錯誤預測,只有一個正確預測」的事實基礎上,透過結合具有不同優缺點的預測模型,那些產生準確預測的模型往往會相互加強,同時抵銷錯誤的預測。這種結合多個預測來提升預測準確性的方法被稱為集成(ensembling)。

- 我們可以利用隨機森林(Random Forest)中來觀察集成效果,隨機森林是多個決策樹的一個總體(ensemble)。

10.3 總體

- 系統性產生不相關決策樹的方法是一種被稱為

「引導聚集算法」(Bootstrap Aggregating Bagging)的技法。

- 引導聚集算法用來創造數千個充分相異的決策樹。為了確保樹與樹之間的最小相關性,

利用預測變量的隨機子集,從訓練用資料集的隨機子集中產生每一顆決策樹。

這使我們能夠產生不同但保持一定預測能力的決策樹。

- 隨機森林通常必決策樹具有更好的預測準確度,因為它善用以下兩種技法:引導聚集算法與集成方法。

- 引導聚集算法在分枝過程中以隨機限制變量的方式來產生一系列不相關的決策樹,而集成方法則是組合這些決策樹的預測結果。

10.5 先天限制

- 不可解讀性:隨機森林被公認為黑盒子,因為隨機森林由隨機產生的決策樹組成,不具有明確的預測規則。舉例來說,我們並不知道隨機森林如何得到預測結果。在預測缺乏明確性的情況下,如果將隨機森林演算法應用到醫學診斷領域,有可能會面臨倫理問題。儘管如此,隨機森林因為容易執行而被廣泛使用。特別適用於當預測結果準確度可解讀性更為重要的情境之中。

Ch11|類神經網路

11.1 建立一顆大腦

- 近期類神經網路的流行可歸結於三個主要原因:

1. 資料儲存與分享的進展:提供可以用於訓練的大量資料,從而改善類神經網路的表現。

2. 運算能力提升:比核心處理器速度快上150倍的圖像處理器(GPUs),過去主要被用來顯示高畫質的電腦遊戲畫面,現在被當作在大型資料集中訓練神經網路的強力引擎。

3. 演算法效能被強化:儘管機器效能要達到人腦水準尚有一段距離,目前已經開發了一些顯著提升效能的新技術。

- 自動化圖像識別技術是類神經網路應用的優秀例子,可以應用到許多領域,包括視覺監控、自動導航等。甚至在智慧型手機的應用上,可以辨識手寫文字。

11.3 類神經網路的組成

- 典型的類神經網路由下列構造所組成:

1. 輸入層:這一層神經元處理所有新進圖像的像素點。因此,神經元樹量可能和圖像中的向速點數量一樣多。為了簡潔起見,我們將無數個神經元在圖中省略地以單個節點呈現。為了改善預測,可以使用卷積層。這層不再是處理獨立的像素點,而是改為辨識像素點組合所形成的特徵。因為這種分析方式只依賴特徵本身而非特徵的位置。所以即使關鍵特徵偏離了圖像中心,類神經網路能夠辨識出該數字-這個特性被稱為平移不變性(Translational Invariance)。

2. 隱藏層:當像素點進入類神經網路後,它們會經歷多層轉換,增加這些圖像與類神經網路之前看過的圖像(已知標籤)的整體相似性。儘管越多次轉換越能增加更高的準確率,但運算處理時間也顯著變長。

一般來說,只需要幾次轉換就夠了。在每一層中,神經元的數量應該與圖像中的像素點數量成正比。

3. 輸出層:最後的預測結果顯示在這一層,輸出層可能只有一個神經元,或者和可能的預測結果數量一樣多。

4. 損失層:在訓練類神經網路時會出現一個損失層。通常被放在最後的這一層,會針對輸入資料是否被正確辨識給予回饋,如果沒有成功辨識,則回報錯誤的程度。

- 損失層對於類神經網路的訓練來說至關重要。如果做出了正確的預測,那麼來自損失層的反饋將會增強產生該預測的活化途徑。如果做出了錯誤預測,錯欲將沿著該活化途徑被反向回饋,如此一來,沿著這條路徑的神經元就會重新調整它們的活化標準,減少錯誤發生。這個過程被稱為後向傳播(Backpropagation)。

- 透過著個迭代的訓練過程,類神經網路將會學習將輸入資料與正確輸出標籤相關聯,而且這些習得的關聯將會被編寫為每個神經元的活化法則。

11.4 活化法則

- 當資料集很龐大,且具備先進運算設備時,使用類神經網路的成效最佳,然而演算結果通常不具可解釋性。

11.5 先天限制

- 龐大樣本量需求:類神經網路的複雜性使其能夠識別具有複雜特徵的輸入資料,但只有具備可用於訓練的大量資料才能這麼做。如果訓練用資料集規模太小,可能會導致「過適」情形。不過,若是取得更多訓練用資料太過麻煩,我們可以使用下列技術來盡可能減少出現「過適」情形的風險。

1.次取樣:為了降低神經元對雜訊的靈敏度,可以利用被稱為次取樣(Subsampling)的步驟,對信號樣本取平均值,將輸入的資料「平整化」。舉例來說,如果想對圖像做次取樣,我們可以減少圖像大小,或是將低色彩對比度。

2.失真(Distortion):如果訓練用資料不足,我們可以對每張圖像導入「失真」來建立更多資料。透過將每張失真的圖像視為新的資料,可以擴大用來訓練類神經網路的資料量。類神經網路所使用的失真圖像應該反映原始資料集中出現的失真情形。

舉例來說,在手寫數字的例子中,可以旋轉圖像來模仿某些人如何以某角度書寫,或著是延伸或擠壓某些特定部分(稱為彈性變形)來模擬手部肌肉不受控制的震動。

3.脫落(Dropout):如果沒有什麼可以用來訓練的樣本,不同神經元形成關聯的機會就會減少,容易產生「過適」情形,因為小神經的群集間形成過度依賴。為了解這個問題,我們可以在一次訓練週期中,隨機排除半數神經元。這些脫落的神經元將被停止活化,而其他剩餘神經元依舊正常運作,就好像脫落的神經元不存在一樣。在下一次訓練迭代中則使用一組不同的脫落神經元。這正是脫落(Dropout)技法迫使不同組合的神經元一起作用的方法,從而在訓練樣本中發現更多特徵。

- 運算成本高昂:訓練一個包含數千個神經元的類神經網路可能曠日費時。隨然升級運算設備是個簡單的解決方式,但代價可能相當高昂。

另一個解決辦法是調整演算法用較低的預測準確度來換取更快的運算速度。可以利用下列方式:

1.隨機梯度下降:在典型的梯度下降演算法中,我們再一次迭代中循環了所有訓練用樣本更新單一參數。因為這項作法對大型資料集中相當耗時,替代方案是在每次迭代中使用一個訓練用樣本來更新參數。這個技法被稱為隨機梯度下降(Stochastic gradient descent),雖然產生的參數值可能不是最佳的,但它們已具備相當不錯的準確性。

2.小批量梯度下降:儘管在每次迭代中只參考一訓練樣本可能更有效率,但是代價可能是最後所得到的參數值不夠精確,且演算法可能較為發散,導致參數擺盪於最佳值附近。有一個折衷辦法是參考每次迭代所使用的訓練用樣本「子集」,這個方法被稱為小批量梯度下降(mini-batch gradient descent)。

3.完全連結的神經層:當我們增加越多神經元,可能的神經路徑之數量則以指數增長。為了避免檢驗所有可能組合,我們可以讓最初幾層的神經元-那些處理較小、較低階特徵的神經元,處於部分連結的狀態。只有最後幾層-處理大型、高階特徵的神經元層,需要與相鄰神經元層的神經元完全連結。

- 結果不具可解讀性:類神經網路由多個神經元層組成,每一個神經元層內有數百個由不同活化法則控制的神經元。這項特徵使的我們很難判斷出哪一個特定輸入信號的組合會產生正確預測。類神經網路並不像迴歸分析演算法,可以明確辨識出顯著預測因子並進行比較。類神經網路的黑盒子特性使得人們很難證明其用途,尤其在道德決策方面。雖然如此,我們仍在繼續研究每個神經層的訓練進度,來檢驗獨立得輸入信號如何影響預測結果。

Ch12|A/B測試與多拉桿吃角子老虎機

12.2 A/B測試的限制

- A/B測試方法有兩個問題

1.可能只是僥倖的測試結果

2.損失潛在收入

12.3 Epsilon-Decreasing策略

- Epsilon指的是透所另一種替代方案並確認這個方案的確成效較差,所花費的時間比例。因為我們減少了Epsilon,對於效果更好的廣告越有信心,這種技術屬於增強學習(Reinforcement learning)演算法。

-多拉桿吃角子老虎機問題針對如何對資源進行最佳分配的探索:究竟要深度開發已知回報,或是繼續尋找更好的替代方式。

- 一種解決方案是先找出可能選項,在將剩餘的資源全部投入到成效最好的選項中。這個策略稱為A/B測試。

- 另一種方式則是對成效最好的選項逐步增加資源分配比例,這個方法叫做Epsilon-Decreasing策略。

- 儘管大多數狀況下Epsilon-Decreasing策略比A/B測試有著更高的回報率,但想要找出更新資源分配的最佳速率時非易事。

12.6 Epsilon-Decreasing 策略的限制

1.曝光為固定的,不因時間推移而改變:假如有一則廣告在早上的曝光度比晚上好,另一則廣告在全天中的曝光度無顯著差異。這時若我們在早上比較這兩則廣告,那很有可能做出錯誤判斷,認為第一則廣告的成效比較好。

2.賠率與之前的遊戲無關:如果多次投放同一則廣告,消費者可能會被挑起好奇心,刺激他/她點擊該廣告。這表示我們需要進行重複探索,才能呈現真實的「期望購買機率」。

3.操作後與實際獲得回響之間的最小延遲時間:如果一則廣告經由電子郵件發送,可能需要等待幾天時間,潛在買家才會做出回應。這個情況會阻礙我們立刻瞭解探勘的真實結果,此時因為資訊不夠完整,任何深度開發的嘗試都是不全面的。

專業名詞:

- Activation Rile(活化規則):神經元被活化之前,必須接收輸入信號。活化原則是規範信號來源與強度的標準。神經元的活化經過神經網路傳播,產生預測。

- Aprori Principle(先驗原則):當一個項目集被判定為不頻繁,那麼任何包含這個項目集的更大項目集也是不頻繁的。在判斷項目頻率與關聯性時,,先驗原則是一種用來減少檢測數量的技術。

- Association Rule(關聯規則):關聯規則是一種非監督式學習演算法,用來發掘資料點之間的關聯性,例如識別出哪些項目經常被一起購買。

關聯規則有三種常用指標:

1.{X}的支持度代表項目X的出現頻率

2.{X->Y}的可信度代表當項目X出現時,項目Y也出現的頻率。

3.{X->Y}的增益值項目X與項目Y同時出現的頻率,同時也考慮項目各自出現的頻率。

- Backpropagation(倒傳遞):在神經網路中傳遞迴饋訊息,判斷預測是否正確的過程。假如預測是錯誤的,那麼該錯誤會透過神經網路向後傳遞,如此一來,沿著這條路徑的神經網原就會重新校正活化標準,以減少錯誤發生。

- Boostrap Aggregating (Bagging)(引導聚集演算法、裝袋算法):用來創造數以千計不相關的決策樹的演算法,取所有預測的平均值,以避免出現過適。所有樹由訓練資料的隨機子集合中產生,在所有樹的分枝使用預測變數的隨機子集進行選擇。

- Confusion Matrix(混淆矩陣):一種評估分類預測準確性的方法。除了整體分類的準確性,混淆矩陣可以顯示偽陽性與偽陰性的比例。

- Correlation(相關):測量兩個變數之間的線性關係的方法。相關係數的範圍在-1至1之間,並提供兩項資訊:(1)關聯的強度,最大值為-1或1,最小值為0(2)關聯的方向性,當兩個變數巢一個方向移動為正相關,相反方向移動則為負相關。

- Cross-Validation(交叉驗證):「交叉驗證」是一種將資料用可用性最大化的方法。將資料集劃分為多個用來重複驗試模型的資料片段,最大化可用於驗證的資料。在單次迭代中,除了一個片段之外,將所有其餘片段用來訓練該預測模型,然後隊最後一個片段進行預測。這個驗證過程將被重複,直到每個片段都恰好當過一次驗試片段。模型準確度的最終預測值為所有迭代的結果平均值。

- Dimension Reduction(降低維度):降低維度是一種減少資料變量個數的技法,例如合併高度相關的變量。

- Ensembling(集成):一種結合多個預測模型來改善預測精準度的技法。「集成」之所以有效是因為準確的預測會被互相增強,而錯誤的預測則被抵銷。

- Epsilon-Decreasing Strategy(Epsilon-Decreasing策略):在「探勘更好的替代方案」與「開發已知回報」這兩個階段中分配資源的一種增強學習技法。Epsilon指在探索替代方案所花費的時間比例,當我們掌握了越多關於哪個方案效果最好的資訊,Epsilon值就會減少。

- Feature Engineering(特徵工程):一種從原始資料中產生新變量的過程,講求創新力,例如紀錄獨立變數,或著合併多個變量。

- Gradient Boosting(梯度提升):一種監督式學習演算法,透過選擇不同的二元問題組合在每一棵決策樹上產生分之,形成無數棵決策數。二元問題並非如隨機森林一般以隨機方式解決,而是有策略性地選取,從而提升後續決策數的預測準確度。接著將每一棵樹所作預測結合起來,

給予後續的決策數較大權重,以產生最終預測。

- Gradient Descent(梯度下降):一種校準模型參數的技法。首先對一組參數值進行初步預估,接著進行迭代,將預估值應用到每個資料點以獲得預測,然後調整預估值,減少整體預測誤差。

- K-Means Clustering(K-平均分離):一種非監督式學習演算法,將相似的資料點分到同一個群集,k代表需要進行是別的群集數量。

- K-Nearest Neighbors(K-最近鄰):一種監督式學習演篹法,透過參考最相近的其餘資料點的分類,對資料點進行分類,k代表需要參考的資料點數量。

- Kernel Trick(核技巧):一種將資料點投影到更高維度的技法,此時可以用直線對資料點進行區分。

這些直線分界線計算起來較為簡單,當投影回較低維度時,也可以很容易地轉換成曲線。

- Louvain Method:一種非監督式學習演算法,用來識別網路中的群集。在最大群集之內互動的同時,最小化群集之間的互動。

- Multicollinearity(多重共線性):在迴歸分析中,因為變量之間存在高度相關性,導致回歸權重被扭曲解釋的問題。

- Neutral Network(神經網路):神經網路是一種監督式學習演算法,利用神經元層來傳遞用來學習和預測的活化函數。儘管預測高度準確,但由於太過複雜,在某種程度上仍難以解釋預測結果。

- Principal Component Analysis(主成分分析):主成分分析是一種非監督式學習演算法,透過合併資料中最具啟發性的變數,形成新的變數(稱之為主成分),減少必須分析的變數數量。

- Random Forest(隨機森林):隨機森林是一種監督式學習演算法。透過隨機選擇二元問句的不同組合,產生多個決策樹與分枝。加總各獨立決策樹的預測,以形成最終預測。

- Regression Analysis(迴歸分析):迴歸分析是一種監督式學習演算法,用來找出一條通過或接近最多資料點的趨勢線。趨勢線推導自預測變量的加權組合。

- Regularization(正規化):正規化是一種為了避免預測模型出現過適現象,而引入懲罰參數的方法。這個新的參數透過人為添加預測誤差來懲罰任何增加模型複雜度的項目,從而使演算法在優化模型參數時可以保持複雜度及準確性。

- Reinforcement Leaarning(增強學習):一種機器學習演算法,使用資料中的模型進行預測,並在得出更多運算結果的同時優化預測。

- Root Mean Squared Error(方均根差):方均根差事評估為迴歸預測準確性的衡量指標,且特別適用於避免大型誤差:因為將所有獨立的誤差平方,從而放大了大型誤差,使得均方根差對於異常特別靈敏,使異常值被嚴重懲罰。

- Scree Plot(陡坡圖):陡坡圖可用來決定適當的群組數量。群組可以是資料群集或將低維度。在陡坡圖中,使曲線急遽轉彎的點被稱為「扭結」(Kink),它的位置意味著群集的最佳數量,且群集內散佈情形被控制在合理範圍。

- Subsampling(次取樣):一種防止類神經網路模型發生「過適」現象的技法,透過對樣本取平均值,將輸入的資料「平整化」。舉例來說,如果想對圖像做次取樣,我們可以減少圖像大小,或是將低色彩對比度。

- Supervised Learning(監督式學習):監督式學習是一種機器學習演算法,用來產生預測。這類演算法之所以是「監督式的」,原因在於我們希望演算法根據已經存在的模式進行下一步預測。

- Support Vector Machine(支持向量機):一種監督式學習演算法。在兩組邊緣資料點(支持向量)之間,從中畫一條線,將資料點分成兩組。支持向量機採用「核技巧」來有效推導曲線邊界。

- Test Dataset(驗證用資料集):用來評估一個預測模型之準確性與通則性的資料樣本。在訓練用資料集生成預測模型,側是用資料集被預先保留。

- Training Dataset(訓練用資料集):用來找出潛在預測關聯性,產生預測模型的資料樣本。該模型會以獨立的預測用資料集進行評估。

- Translational Invariance(平移不變性):一種卷積類神經網路的屬性,不管圖像特徵位於圖像的哪個位置都能被辨識。

- Validation(驗證):驗證是一種驗證預測模型新資料之準確度的評估方式。將現有的資料集分割為兩個部分:第一部分可以做為訓練用資料集,產生與調整預測模型。第二部分則可做為新進的代理並做為側是用資料集,用來評估預測模型所做出之預測的準確度。

- Variable(變數):描述資料點的資訊。變數又稱為屬性、特徵或維度。變數有下列四種:

二元變數:最簡單的變數型,只有兩種可能選項。(如:男vs女)

類別整數:表現多於兩個變向的變數(種族)

整數變數:呈現整數的變數(如年齡)

連續變數:最為詳盡的變數類型,將數值呈現至小數點。

2020年3月1日 星期日

量化行銷時代

量化行銷時代:貝佐斯與亞馬遜經營團隊都在做,15個關鍵行銷計量指標

第一部分 基礎概念

第一章 贏家與輸家之間的行銷區隔

- 認識15個關鍵行銷計量指標

- 行銷預算花在哪?決定你是贏家還是輸家

- 行銷預算支出類別:

1.製造需求行銷 2.品牌化與知名度 3.顧客權益 4.形塑市場 5.基礎建設

第二章 量化行銷數據,該從哪裡著手?

- 數據導向行銷的5大障礙

突破障礙1:萬事起頭難

突破障礙2:無法辨別行銷活動的因果關係

突破障礙3:缺乏數據資料

- 我要為顧客提供什麼樣的價值,才能讓他們提供資料?

突破障礙4:缺乏資源與工具

突破障礙5:公司其他人拒絕改變

- 為什麼在第一線推動改革如此困難?

因為人們會高估自己既有那套做事方法的價值,並低估改變能夠帶來的價值。

要推動變革最好用的動機,就是製造一個危機:

--我們的預算要被砍36%了,必須極力爭取未來的行銷支出。

--我們的市佔率正在大幅下滑。

--我們的折扣行銷策略,已損及公司的整體獲利能力。

--我們的顧客正在大量流失,而且還不知道那些人是大咖顧客。

--我們的競爭對手在行銷上老是壓著我們打。

- 那麼要如何獲得上級注意,讓你在這場變革中佔有一席之地呢?

每個人都喜歡贏家,因此我要不厭其煩地再次提醒你:

先從小處著手,盡快取得成果,你周遭的人就會注意到你。

接下來你要再做出成績,這可以造就改變的動能,影響他人,

為你在公司裡建立起聲望跟可信度。大家都想要加入連創佳績的團隊

,因此務必設法讓同事們流傳你正在做的事,

並且讓他們看到遵循數據導向行銷原理時,事情會變得多麼順利。

- 只要你能「量測」某件事,就能夠對它加以控制。

- 就行銷而言,讓計量指標跟量測結果在公司內部「公開」,也能夠激勵人們改變

,不過前提是你所量測的東西必須正確。許多公司激勵的是多做活動,

而不是多做出成果,因此重點是要能量測「能夠確實衡量行銷成果」的計量指標。

- 要讓公司裡的資深主管支持並推動相關工作,難度可能堪比攀登聖母峰,

因此,掌握公司的政治氣氛是非常重要的事。先找到想法相近的主管,

讓他們看到運用數據的結果,有可能使行銷工作變得更好、更快、更聰明,

尤其是讓成本變得更低廉後,更能促使他們大力支持配合。

只要你能讓資深主管覺得,新的數據導向行銷是「他們的點子」而不是你的,

那麼距離成功也就不遠了。

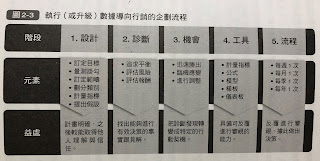

- 執行(或升級)數據導向行銷的企劃流程

- 從蒐集正確的資料著手,迅速獲致成功。問問你自己有哪20%的數據,會產生80%的價值。

- 利用正確的計量指標跟實驗測試行銷點子,突破難以辨別因果關係的障礙。

只要做一些小規模的實驗,就能大幅改善行銷績效。

- 手上的資料不夠嗎?行銷量測可以為未來的行銷支出背書,

等於用1%的努力,獲得99%的價值。

- 要獎勵有做出行銷成果的人,而不是獎勵做出很多行銷活動的人。

把量測結果跟改變行銷文化的動機掛勾,並訓練員工去運用新的工具跟方法。

第三章 10大古典行銷計量指標

- 1960年代誕生的「購買漏斗」(purchasing funnel)行銷行為影響模型指出,

不同的行銷活動,可以引導顧客走過(品牌)知名度、

評估、試驗、建立(顧客)忠誠度等4個階段。

也就是說,經過設計的行銷活動,會像一個漏斗般地「導流」顧客,

從品牌知名度開始,最終令其成為忠實顧客。

- 10大「古典」行銷計劃指標

Tips1:知名度行銷(Awareness Marking)

1號計量指標:品牌知名度(brand awareness)=顧客有多麼容易想起某項產品或服務

Tips2:評估式行銷(Evaluation Marketing):是透過讓顧客比較不同的產品或服務,促進顧客的購買意願。舉凡產品白皮書、列出產品益出跟特色的平面廣告、產品說明小冊子與介紹產品的網站等,

都屬於評估式行銷。

2號計量指標:試駕(test drive)=顧客在購買前預先測試產品或服務

Tips3:忠誠度行銷(Loyalty Marketing):重了重複銷售的數據以外,「客戶流失率」是另一個反應顧客忠誠度的關鍵計量指標。

3號計量指標:客戶流失率(churn)=既有顧客不再回購產品或服務的百分比(通常以1年為量測標準)

- 不知道哪些人是自己客戶的公司,往往也不知道客戶流失率是多少,因次一旦取得這些數據,

量測出來的客戶流失率,很可能會令你大吃一驚。

Tips4:未來銷售的領先指標-顧客滿意度(Customer SATisfaction,CSAT)

4號計量指標:CSAT=顧客滿意度,量測方式:你會把這項產品或服務,推薦給你的朋友或同事嗎?

-有幾個計量指標是從CSAT衍生出來的,比方說「淨推薦值」(Net Promoter Score)。

Tips5:量化「行銷活動績效」的計量指標

5號計量指標:活動接受率(take rate)=接受行銷提案的顧客百分比

- 就網路行銷來說,點擊率(Click-Through Rare,CTR)乘以訂單轉換率(Transaction Conversion Rate,TCR)就當於用網路曝光點擊數來量測活動接受率。

- 潛在客戶轉換率是試用階段的另一個關鍵計量指標,它同樣會反映在營收上。

6號計量指標:利潤(profit)=收入-成本

7號計量指標:NPV=淨現值(Net Pressent Value)

8號計量指標:IRR=內部報酬率(internal rate of return)

9號計量指標:回收期(payback)=行銷投資回收成本所需的時間

- 在行銷的角度上,「顧客終生價值」(Customer LifeTime Value,CLTV)

是一個可以用來前瞻未來的關鍵計量指標範例。

10號計量指標:CLTV=顧客未來價值

- 行銷計分卡通常是給某種特定類型的活動專用,相對的「平衡行銷計分卡」

(Balanced ScoreCard,BSC)所使用的計量指標,可分為三大類:

戰略性指標(領先/前瞻)、戰術性指標(落後/回顧)、營運性指標(內部)。

- 戰略性指標是前瞻的計量指標,包括品牌化、品牌知名度跟顧客滿意度在內,

此外,評估行銷方案的試駕計量指標,以及評估顧客未來價值預測模型所用的CLTV,

也都屬於這一類;財務計量指標則可用於製造需求行銷與某些顧客的行銷活動;

至於營運計量指標是從內部去衡量行銷活動,就營運的觀點去評估行銷活動的效果會有多好。

- 行銷活動要依循大戰略進行,然後再據此選定計量指標。舉例來說,倘若行銷活動的目標是要同時提升品牌知名度和銷售收入,那麼計量指標就應當重於「品牌知名度」和「CSAT」;製造需求行銷的關鍵財務計量指標,反映營運績效的活動接受率,以及與行銷活動有關的成本與績效量測結果。

- 俗話說,1%的努力會產生99%的價值,指的就是「製作計分卡」這件事。

倘若行銷活動獲得成功,計分卡就可以提供實實在在的數據,

為後續的行銷經費背書;就算事情進行得不太順利,計分卡也能夠提早示警,

讓你知道行銷活動的狀況不妙。

第二部分 15個大幅改善行銷績效的計量指標

第四章 5大非財務計量指標

- 1號計量指標:品牌知名度

問題1:提到某項產品或服務,你會最先想到哪間公司或產品?

問題2:提到某項產品或服務,你還聽說過哪些公司或產品?

- 如果你能夠量測到誰做了試駕之後購買產品,就能夠價算出轉換率。

試駕轉換率等於「購買數」除以「試駕數」,我們假設試駕轉換率是20%,

也就是每100次試駕會增加20次產品購買,那麼試駕就能夠跟現金產生關聯,

不過你必須要能夠同時追蹤特定顧客的試駕跟購買行為才行。

- 品牌知名度(1號計量指標):擁有一個很強的品牌,不但能夠使消費者在做購買決策時,

優先想到你的產品或服務,還能使你收取比沒有品牌的競爭者更高的溢價。

利用訪查得到的非財務計量指標,可以追蹤品牌知名度與品牌行銷造成的影響。

- 2號計量指標:試駕=顧客在購買產品或服務之前先行試用。

- 試駕(2號計量指標):評估式行銷的關鍵計量指標。

設計出能夠刺激消費者試用你的產品或服務的評估式行銷,然後量測銷售額轉換率。

- 3號計量指標:客戶流失率=既有顧客在1年、90天或30天內,不再購買某一產品或服務的比率。

- 客戶流失率(3號計量指標):評估忠誠度的關鍵計量指標。

減低客戶流失率可對公司獲利性產生深遠影響。

- 4號計量指標:量測顧客滿意度,必須詢問一個重要問題:

你有多願意把xxx產品、服務或公司,推薦給朋友或同事?

- CSAT(4號計量指標):這個黃金計量指標把品牌化跟顧客忠誠度串聯起來。

CSAT應該要像營收一樣,要主動對它進行管理。

- 5號計量指標:活動接受率

--活動接受率(行銷績效)的計算方式為:活動接受率=接收行銷提案的人數/接觸數

--每位顧客的取得成本(AC)計算方式為:

AC=每次接觸成本X接觸數/接受行銷提案的人數=每次接觸成本/活動接受率

- 活動接受率(5號計量指標):行銷營運的關鍵計量指標。

提升活動接受率並減低顧客取得成本(AC),可大幅改善行銷的成本面。

第五章 嘿,把行銷計畫的ROI給我!

- 6號計量指標:利潤=收入-成本

- 7號計量指標:淨現值(NPV)=PV(現值)-成本

- 8號計量指標:內部報酬率(IRR)=金錢在行銷活動或計畫內部的複利率

- 9號計量指標:回收期=「現金利潤」等於「成本」所需的時間

第六章 顧客,並非生而平等

- 10號計量指標:顧客終身價值(CLTV)

- CLTV方程式跟傳統NPV方程式的差別,在於顧客是否「會留下」的或然率p,

又叫做留存率。留存率相當於1減掉顧客跑掉的或然率:p=1-c

c是4號計量指標的「客戶流失率」。也就是說,顧客在一年內會留下得或然率p,

相當於1減掉顧客流失率。

- 把產品綑綁銷售給高價值顧客,還有把他們綁住的好處-倘若顧客想要換到競爭廠商那裡,

轉換成本就變得很大。

- 對於那些負價值的顧客,要想辦法把他們移往成本較低的服務管道,並且積極管理服務成本;

對於那些高價值的顧客,就要想辦法留住他們,並且對其進行增售跟交叉銷售。

至於那些中價值的顧客,則是要找出可以使他們成為高價值顧客的交叉銷售項目,

並且把行銷重點放在這上頭。

- 加拿大皇家銀行依據顧客的特定利潤、風險、客戶流失率、CLTV等計量指標,

找出適合為他們提供的顧客服務與行銷互動方式。

- 10號計量指標:顧客終生價值(CLTV),是量測顧客未來價值的關鍵計量指標。

- 沒有負獲利性的顧客,只有負獲利性的業務流程或服務管道。

你必須找出這些導致公司價值減損之處,然後加以改變。

第七章 5大網路行銷計量指標

第三部分 更上一層樓

第八章 立即提升5倍績效的敏捷式行銷

第九章 哇,那個產品正是我需要的!

第十章 量化行銷,需要付出多少代價?

第十一章 從仿效到卓越,讓行銷管理最佳化

第一部分 基礎概念

第一章 贏家與輸家之間的行銷區隔

- 認識15個關鍵行銷計量指標

- 行銷預算花在哪?決定你是贏家還是輸家

- 行銷預算支出類別:

1.製造需求行銷 2.品牌化與知名度 3.顧客權益 4.形塑市場 5.基礎建設

第二章 量化行銷數據,該從哪裡著手?

- 數據導向行銷的5大障礙

突破障礙1:萬事起頭難

突破障礙2:無法辨別行銷活動的因果關係

突破障礙3:缺乏數據資料

- 我要為顧客提供什麼樣的價值,才能讓他們提供資料?

突破障礙4:缺乏資源與工具

突破障礙5:公司其他人拒絕改變

- 為什麼在第一線推動改革如此困難?

因為人們會高估自己既有那套做事方法的價值,並低估改變能夠帶來的價值。

要推動變革最好用的動機,就是製造一個危機:

--我們的預算要被砍36%了,必須極力爭取未來的行銷支出。

--我們的市佔率正在大幅下滑。

--我們的折扣行銷策略,已損及公司的整體獲利能力。

--我們的顧客正在大量流失,而且還不知道那些人是大咖顧客。

--我們的競爭對手在行銷上老是壓著我們打。

- 那麼要如何獲得上級注意,讓你在這場變革中佔有一席之地呢?

每個人都喜歡贏家,因此我要不厭其煩地再次提醒你:

先從小處著手,盡快取得成果,你周遭的人就會注意到你。

接下來你要再做出成績,這可以造就改變的動能,影響他人,

為你在公司裡建立起聲望跟可信度。大家都想要加入連創佳績的團隊

,因此務必設法讓同事們流傳你正在做的事,

並且讓他們看到遵循數據導向行銷原理時,事情會變得多麼順利。

- 只要你能「量測」某件事,就能夠對它加以控制。

- 就行銷而言,讓計量指標跟量測結果在公司內部「公開」,也能夠激勵人們改變

,不過前提是你所量測的東西必須正確。許多公司激勵的是多做活動,

而不是多做出成果,因此重點是要能量測「能夠確實衡量行銷成果」的計量指標。

- 要讓公司裡的資深主管支持並推動相關工作,難度可能堪比攀登聖母峰,

因此,掌握公司的政治氣氛是非常重要的事。先找到想法相近的主管,

讓他們看到運用數據的結果,有可能使行銷工作變得更好、更快、更聰明,

尤其是讓成本變得更低廉後,更能促使他們大力支持配合。

只要你能讓資深主管覺得,新的數據導向行銷是「他們的點子」而不是你的,

那麼距離成功也就不遠了。

- 執行(或升級)數據導向行銷的企劃流程

- 從蒐集正確的資料著手,迅速獲致成功。問問你自己有哪20%的數據,會產生80%的價值。

- 利用正確的計量指標跟實驗測試行銷點子,突破難以辨別因果關係的障礙。

只要做一些小規模的實驗,就能大幅改善行銷績效。

- 手上的資料不夠嗎?行銷量測可以為未來的行銷支出背書,

等於用1%的努力,獲得99%的價值。

- 要獎勵有做出行銷成果的人,而不是獎勵做出很多行銷活動的人。

把量測結果跟改變行銷文化的動機掛勾,並訓練員工去運用新的工具跟方法。

第三章 10大古典行銷計量指標

- 1960年代誕生的「購買漏斗」(purchasing funnel)行銷行為影響模型指出,

不同的行銷活動,可以引導顧客走過(品牌)知名度、

評估、試驗、建立(顧客)忠誠度等4個階段。

也就是說,經過設計的行銷活動,會像一個漏斗般地「導流」顧客,

從品牌知名度開始,最終令其成為忠實顧客。

- 10大「古典」行銷計劃指標

Tips1:知名度行銷(Awareness Marking)

1號計量指標:品牌知名度(brand awareness)=顧客有多麼容易想起某項產品或服務

Tips2:評估式行銷(Evaluation Marketing):是透過讓顧客比較不同的產品或服務,促進顧客的購買意願。舉凡產品白皮書、列出產品益出跟特色的平面廣告、產品說明小冊子與介紹產品的網站等,

都屬於評估式行銷。

2號計量指標:試駕(test drive)=顧客在購買前預先測試產品或服務

Tips3:忠誠度行銷(Loyalty Marketing):重了重複銷售的數據以外,「客戶流失率」是另一個反應顧客忠誠度的關鍵計量指標。

3號計量指標:客戶流失率(churn)=既有顧客不再回購產品或服務的百分比(通常以1年為量測標準)

- 不知道哪些人是自己客戶的公司,往往也不知道客戶流失率是多少,因次一旦取得這些數據,

量測出來的客戶流失率,很可能會令你大吃一驚。

Tips4:未來銷售的領先指標-顧客滿意度(Customer SATisfaction,CSAT)

4號計量指標:CSAT=顧客滿意度,量測方式:你會把這項產品或服務,推薦給你的朋友或同事嗎?

-有幾個計量指標是從CSAT衍生出來的,比方說「淨推薦值」(Net Promoter Score)。

Tips5:量化「行銷活動績效」的計量指標

5號計量指標:活動接受率(take rate)=接受行銷提案的顧客百分比

- 就網路行銷來說,點擊率(Click-Through Rare,CTR)乘以訂單轉換率(Transaction Conversion Rate,TCR)就當於用網路曝光點擊數來量測活動接受率。

- 潛在客戶轉換率是試用階段的另一個關鍵計量指標,它同樣會反映在營收上。

6號計量指標:利潤(profit)=收入-成本

7號計量指標:NPV=淨現值(Net Pressent Value)

8號計量指標:IRR=內部報酬率(internal rate of return)

9號計量指標:回收期(payback)=行銷投資回收成本所需的時間

- 在行銷的角度上,「顧客終生價值」(Customer LifeTime Value,CLTV)

是一個可以用來前瞻未來的關鍵計量指標範例。

10號計量指標:CLTV=顧客未來價值

- 行銷計分卡通常是給某種特定類型的活動專用,相對的「平衡行銷計分卡」

(Balanced ScoreCard,BSC)所使用的計量指標,可分為三大類:

戰略性指標(領先/前瞻)、戰術性指標(落後/回顧)、營運性指標(內部)。

- 戰略性指標是前瞻的計量指標,包括品牌化、品牌知名度跟顧客滿意度在內,

此外,評估行銷方案的試駕計量指標,以及評估顧客未來價值預測模型所用的CLTV,

也都屬於這一類;財務計量指標則可用於製造需求行銷與某些顧客的行銷活動;

至於營運計量指標是從內部去衡量行銷活動,就營運的觀點去評估行銷活動的效果會有多好。

- 行銷活動要依循大戰略進行,然後再據此選定計量指標。舉例來說,倘若行銷活動的目標是要同時提升品牌知名度和銷售收入,那麼計量指標就應當重於「品牌知名度」和「CSAT」;製造需求行銷的關鍵財務計量指標,反映營運績效的活動接受率,以及與行銷活動有關的成本與績效量測結果。

- 俗話說,1%的努力會產生99%的價值,指的就是「製作計分卡」這件事。

倘若行銷活動獲得成功,計分卡就可以提供實實在在的數據,

為後續的行銷經費背書;就算事情進行得不太順利,計分卡也能夠提早示警,

讓你知道行銷活動的狀況不妙。

第二部分 15個大幅改善行銷績效的計量指標

第四章 5大非財務計量指標

- 1號計量指標:品牌知名度

問題1:提到某項產品或服務,你會最先想到哪間公司或產品?

問題2:提到某項產品或服務,你還聽說過哪些公司或產品?

- 如果你能夠量測到誰做了試駕之後購買產品,就能夠價算出轉換率。

試駕轉換率等於「購買數」除以「試駕數」,我們假設試駕轉換率是20%,

也就是每100次試駕會增加20次產品購買,那麼試駕就能夠跟現金產生關聯,

不過你必須要能夠同時追蹤特定顧客的試駕跟購買行為才行。

- 品牌知名度(1號計量指標):擁有一個很強的品牌,不但能夠使消費者在做購買決策時,

優先想到你的產品或服務,還能使你收取比沒有品牌的競爭者更高的溢價。

利用訪查得到的非財務計量指標,可以追蹤品牌知名度與品牌行銷造成的影響。

- 2號計量指標:試駕=顧客在購買產品或服務之前先行試用。

- 試駕(2號計量指標):評估式行銷的關鍵計量指標。

設計出能夠刺激消費者試用你的產品或服務的評估式行銷,然後量測銷售額轉換率。

- 3號計量指標:客戶流失率=既有顧客在1年、90天或30天內,不再購買某一產品或服務的比率。

- 客戶流失率(3號計量指標):評估忠誠度的關鍵計量指標。

減低客戶流失率可對公司獲利性產生深遠影響。

- 4號計量指標:量測顧客滿意度,必須詢問一個重要問題:

你有多願意把xxx產品、服務或公司,推薦給朋友或同事?

- CSAT(4號計量指標):這個黃金計量指標把品牌化跟顧客忠誠度串聯起來。

CSAT應該要像營收一樣,要主動對它進行管理。

- 5號計量指標:活動接受率

--活動接受率(行銷績效)的計算方式為:活動接受率=接收行銷提案的人數/接觸數

--每位顧客的取得成本(AC)計算方式為:

AC=每次接觸成本X接觸數/接受行銷提案的人數=每次接觸成本/活動接受率

- 活動接受率(5號計量指標):行銷營運的關鍵計量指標。

提升活動接受率並減低顧客取得成本(AC),可大幅改善行銷的成本面。

第五章 嘿,把行銷計畫的ROI給我!

- 6號計量指標:利潤=收入-成本

- 7號計量指標:淨現值(NPV)=PV(現值)-成本

- 8號計量指標:內部報酬率(IRR)=金錢在行銷活動或計畫內部的複利率

- 9號計量指標:回收期=「現金利潤」等於「成本」所需的時間

第六章 顧客,並非生而平等

- 10號計量指標:顧客終身價值(CLTV)

- CLTV方程式跟傳統NPV方程式的差別,在於顧客是否「會留下」的或然率p,

又叫做留存率。留存率相當於1減掉顧客跑掉的或然率:p=1-c

c是4號計量指標的「客戶流失率」。也就是說,顧客在一年內會留下得或然率p,

相當於1減掉顧客流失率。

- 把產品綑綁銷售給高價值顧客,還有把他們綁住的好處-倘若顧客想要換到競爭廠商那裡,

轉換成本就變得很大。

- 對於那些負價值的顧客,要想辦法把他們移往成本較低的服務管道,並且積極管理服務成本;

對於那些高價值的顧客,就要想辦法留住他們,並且對其進行增售跟交叉銷售。

至於那些中價值的顧客,則是要找出可以使他們成為高價值顧客的交叉銷售項目,

並且把行銷重點放在這上頭。

找出適合為他們提供的顧客服務與行銷互動方式。

- 10號計量指標:顧客終生價值(CLTV),是量測顧客未來價值的關鍵計量指標。

- 沒有負獲利性的顧客,只有負獲利性的業務流程或服務管道。

你必須找出這些導致公司價值減損之處,然後加以改變。

第七章 5大網路行銷計量指標

第三部分 更上一層樓

第八章 立即提升5倍績效的敏捷式行銷

第九章 哇,那個產品正是我需要的!

第十章 量化行銷,需要付出多少代價?

第十一章 從仿效到卓越,讓行銷管理最佳化

位置:

台灣台北

訂閱:

文章 (Atom)